大模型“卷”出天际,AI推理能否轻盈飞翔?

近一个月以来,业界最热闹的事件莫过于大模型集体降价。在你方唱罢我登场的一番操作之后,大模型的使用门槛向“免费”逐渐靠拢,AI应用大爆发的时间窗越来越近。

当基础设施朝着普惠化不断迈进,精彩纷呈的应用才会持续涌现——这一幕在移动互联网崛起时曾上演过,AI新时代也很可能依循类似的演进轨迹,“推理”将替代“训练”成为舞台上真正的主角。

根据权威研究机构的测算,到2028年人工智能的推理负载占比有望达到85%,考虑到云端和边缘侧巨大的推理需求,未来推理芯片的预期市场规模将是训练芯片的4~6倍。

事实上,在AI的全生命周期中,训练与推理是相互依存的两个重要组成部分。前者将海量数据输入模型,通过高强度的处理使模型识别复杂的数据模式;后者则基于训练好的模型,实时处理输入的数据,在更贴近数据的位置执行特定任务。

显而易见,AI训练与推理因各自定位不同,对算力底座的需求存在显著差异。AI训练需要大规模算力的支撑,通常优先使用并行能力更强的GPU或专用的AI加速器;而AI推理往往只需较小的算力,更强调持续运算与低延迟,兼具高性能、低能耗、高性价比等多重优势的CPU备受青睐。

当AI推理的占比日益上升之时,CPU“凤舞九天”的日子还会远吗?实际情况没有想象中那么简单,能带着用户一起轻盈飞翔的CPU可谓凤毛麟角,第四代AMD EPYC处理器的路径探索值得借鉴。

AI推理的痛点及对CPU的期望

值得关注的是,AI推理出现的时间较早,其范畴不仅涉及近两年火爆的大模型,还包括计算机视觉、推荐系统等已被各个行业广泛使用的AI模型。

以计算机视觉模型与推荐系统的协同运作为例:在制造业,计算机视觉模型能监控从食品到印刷电路板等制成品的质量,若把遥测数据输入推荐引擎,更可提出主动维护建议;在金融服务业,由AI推荐系统驱动的异常检测可有效阻止信用卡欺诈,而计算机视觉模型则能监控包括客户支票在内的可疑文件。

毋庸置疑,由于AI推理扮演的主要角色是对已训练模型的决策或识别,擅长处理复杂逻辑和控制流任务的CPU能够应对诸多场景的一般性问题。但AI推理所处的环境也在发生剧烈变化,CPU在实践中面临多维度的新挑战。

从落地应用的角度看,AI推理的身影会出现在零售店、行驶中的汽车、工厂车间、医院放射科等纷繁复杂的场景,这意味着其经常在不同的软硬件平台上运行,并腾挪于云端与边缘侧——这对CPU在各类设备上的通用性提出更高要求,且期望其在性能、功耗、成本等核心指标之间达成动态平衡。

更为重要的是,伴随深度学习模型复杂度的不断提升以及参数量的几何级数增长,AI推理任务可能涉及大量矩阵运算和向量运算,并要频繁访问模型参数和中间数据,这需要CPU具备高性能、大缓存、高IO带宽等综合优势,只靠省钱的低配版即可吸引客户的时代已一去不返。

第四代AMD EPYC为AI推理插上腾飞的翅膀

不难看出,AI推理正处于全面跃迁的关键节点,以CPU为核心的算力底座亟待升级。每一个痛点都蕴藏着机遇,需要智勇双全的探路者点石成金。

作为拥有高性能GPU、CPU及各种平台解决方案的行业领头羊,AMD深谙AI全生命周期的演进规律,其基于EPYC CPU构建的算力基础设施已成为最受客户青睐的AI推理平台,第四代AMD EPYC更为AI推理插上腾飞的翅膀。

战地摄影师罗伯特·卡帕曾说,“如果你拍得不够好,是因为你离得不够近。”这个观点在AI推理领域同样适用——由于AI推理通常在靠近数据的位置进行,搭载AMD EPYC CPU的服务器也部署于此,随时准备执行任务。无论是金融、制造、消费等传统行业,还是医疗、零售等新兴领域,AMD EPYC驱动的服务器都能为客户的AI推理保驾护航。

位置上离客户近还不足够,走进他们的心里更难能可贵。其中一个重要途径,就是最大限度降低客户AI部署、开发和应用门槛——AMD EPYC采用各个行业用户最驾轻就熟的x86架构指令集,相当于赢在了起跑线上。

从某种意义上讲,第四代AMD EPYC的脱颖而出让AI推理迈上更高的台阶。与上一代处理器相比,全新的Zen 4架构使每时钟周期执行指令总数增加约14%,更高的频率促进性能大幅提升,显著拉高了AI推理适应各种工作负载的天花板。

针对AI推理在高并发、低延迟场景的迫切需求,第四代AMD EPYC的核心与线程数量猛增50%以上,并支持同步多线程,无需GPU加速就能进行更多并行推理操作,即使处理上万个源的数据推理需求也应付裕如。

尤值一提的是,为帮助AI推理应对矩阵和向量计算的挑战,第四代AMD EPYC具备灵活高效的AVX-512扩展指令集,支持BF16数据类型以提高吞吐量,规避了INT8数据的量化风险,且双周期、256位流水线设计有助于提高AI推理的运行效率。

Phoronix通过使用TensorFlow210和BF16数据类型运行Res-Net-50模型,验证了AVX-512对AI推理的独特价值:在同一台服务器上开启和关闭AVX -512指令的场景下,发现开启AVX -512时,性能提高了1.73倍,且对时钟频率的影响很小,每瓦每秒处理的图像数几乎翻倍,这在人脸识别等热门应用中将起到不可替代的作用。

其实,AI推理的“野心”不局限于轻量级或通用型场景,要想在高性能计算、科学计算等金字塔尖上施展拳脚,显然离不开算力底座的进一步升级。第四代AMD EPYC拥有更强大的内存与I/O,引入DDR5内存并支持多达12个通道,特别是在9084X系列中采用3D V-Cache技术,三级缓存容量高达1.1GB,能满足高负载及缓存敏感型场景的极致要求。

如果说CPU性能的全方位增强为AI推理的起飞提供了充足的动力,那么能耗和成本的降低则为AI推理的轻盈飞翔创造了必要条件。第四代AMD EPYC的能效水平处于业界领先地位,96核心的热设计功耗只需360W;同时,各个系列处理器的性价比颇具竞争优势,为AI推理的普惠化奠定了坚实基础。

AI推理的终极目标比远方更远

近一段时间,人工智能领域的多位大咖纷纷表示看好AI推理的发展前景,更有研究机构做出这样的预测:AI推理对算力的总需求将会远超AI训练,可能是5倍、10倍,甚至更高。

既然想象空间已彻底打开,快马加鞭就是大家的共同选择。在备受瞩目的Computex 2024上,AMD预览了将于今年下半年发布、具有领先性能和效率的第五代AMD EPYC 服务器处理器,比第四代产品又向前迈出一大步:Zen5架构的指令集带宽增加2倍以上,缓存之间的数据带宽也提升2倍,每时钟周期指令集平均提高16%,部分项目的擢升幅度逾20%。

尽管第五代AMD EPYC不是为AI推理量身定制的处理器,其应用场景非常广阔,但其每一项指标的提升又必然为AI推理的进化添薪加柴。从未来5到10年的视角看,人工智能的落地进程将渐入佳境,AI推理任重而道远,属于新一代CPU的华彩乐章值得期待。

内容转载自:IT创事记

推荐资讯

20辆豪沃TH7危化品燃气牵引车交付淄博大客户,为危化品运输保驾护航

广汽.商城创始人魏新:机会面前人人平等!!!!

全媒社携手澳大利亚城市明星网红,打造最新合作计划

心鑫金缘珠宝积极布局全国 目标六年内开设2000家子公司

温州市洞头中西医结合理疗研究所发明的仙手牌远红外系列产品为人类预防肿瘤中风胸痛等疾病多年总结效佳

冠军之路益智运动会暨NSIC 益智国游大赛总决赛圆满落幕

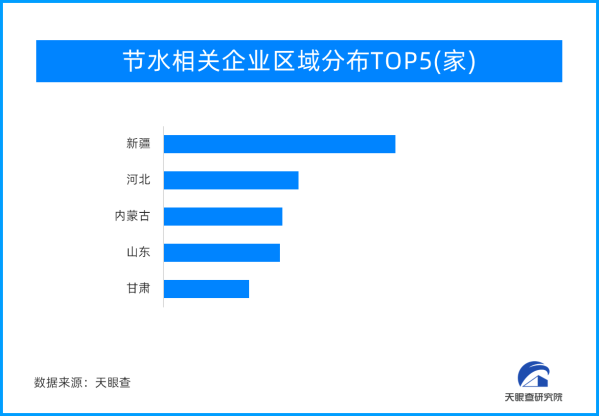

节约用水 人人有责!国家层面首次“节水”立法

餐厨余烬,规范重生 | 贺州高能助推“无废城市”建设新生态

人民网对话徐浩宇代表:坚持创新主导 赋能大健康产业高质量发展